華視新聞 連珮貝 張政捷 報導 / 台北市

DEEP FAKE「變臉」技術出現,讓眼見不再為憑,這樣的技術,就怕被有心人拿來當武器,可怕的是,不只是名人受害,每一個人都有機會被這樣的技術栽贓,該如何自保?律師提醒、如果肖像被盜用,做成不堪入目的影片或圖片,可先提起民事假處份,禁止再被引用,再向對方提告妨害名譽等,不過技術人員也說、隨著科技越來越進步,要分辨真假恐怕會越來越有難度。

將韓國瑜的照片匯入電腦程式,系統分析照片後,韓國瑜的喜怒哀樂,表情細小到嘴角的變化,電腦都可以輕易調整做出,這就是DEEP FAKE像是變臉的技術,接著就能將頭像合成到相關影片上。

動畫軟體公司產品經理 余家安:「需要有一個很好的照片,因為越好的照片,可以做出越真越逼真的角色,如果表演者就已經跟這個人的神情姿態,很相似的時候,那就可以表演的更真。」

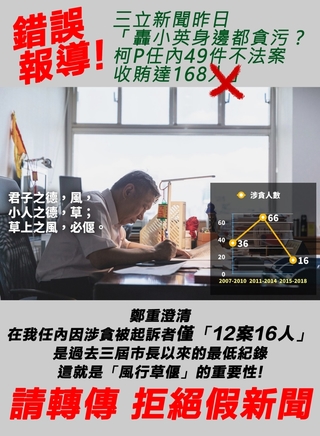

DEEPFAKE深假技術,原本是電影動畫公司,為了節省成本,而開發出來的技術,現在就怕成了有心人士的武器,尤其選舉將近,這類的造假恐影響選情,中正大學傳播學系教授 胡元輝:「人工智慧的運用,就可以結合出讓人信以為真的影片,一定會在選舉的時候被運用,所以現在大家都在提防這樣的事情。」

但未來恐怕不只名人受害,每人都可能成為被汙陷的對象,如果肖像被盜用做成不雅圖片影片,我們該如何自保?律師 劉韋廷:「是可以提告的假處份去禁止這些A片繼續散布,當然也可以透過刑事扣押的程序,讓這些A片沒辦法繼續散布,再者可以提起民事的人格權損害賠償,以及禁止他再散布的訴訟,當然刑事也可以提告妨礙名譽。」

要怎麼分辨真假,動畫公司也坦言,隨著科技進步,技術只會越來越精細,相關單位應正視問題,開發可快速辨識的鑑識技術。

新聞來源:華視新聞

讀者迴響